Table of Content [Tutup]

Blogger Robots.txt Generator

Robots.txt: Pengertian, Kegunaan, dan Cara Membuatnya

File robot.txt merupakan hal yang perlu diperhatikan penggunaannya. Dengan adanya robot.txt, mesin pencari (search engine) dapat dengan mudah menelusuri konten yang ada pada website Anda. Crawler mesin pencari mendapatkan informasi dari file robot.txt perihal halaman mana saja yang perlu dan tidak perlu ditelusuri, sehingga dapat meringakan kerjanya dari permintaan yang terlalu banyak.

Kesalahan dalam setting robot.txt justru dapat mengakibatkan web Anda tidak terindeks oleh mesin pencari. Oleh karena itu, perlu informasi bagaimana cara membuat robot.txt yang baik dan benar.

Robot.txt merupakan sebuah file yang di dalamnya terdapat instruksi pada search engine agar spider web crawling dijalankan untuk pengindeksan halaman web.

MOZ menyebutkan bahwa robots.txt akan menentukan software web crawling (user agent) mana saja yang dapat menelusuri sebuah website.

Kegunaan Robot.txt

Berdasarkan uraian di atas, maka dapat di ketahui bahwa fungsi dan kegunaan dari robot.txt adalah untuk menentukan halaman web mana saja yang harus diindex dan halaman mana saja yang tidak perlu diindex oleh web crawling dari search engine.

Dengan adanya robot.txt, maka web dapat dengan mudah dan cepat index search engine dan kesempatan muncul pada halaman pencarian lebih baik.

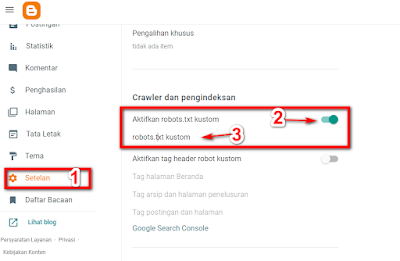

Cara membuat Robot.txt

Untuk mempermudah pembuatan file robot.txt silakan gunakan tools berikut ini. Silakan masukkan URL blogspot Anda. Kemudian pilih, apakah akan menampilkan full sitemap atau Single Sitemap. Terakhir klik generate dan copy semua kode ke dalam blog Anda.

إرسال تعليق